作者:中联科创特约嘉宾尹智

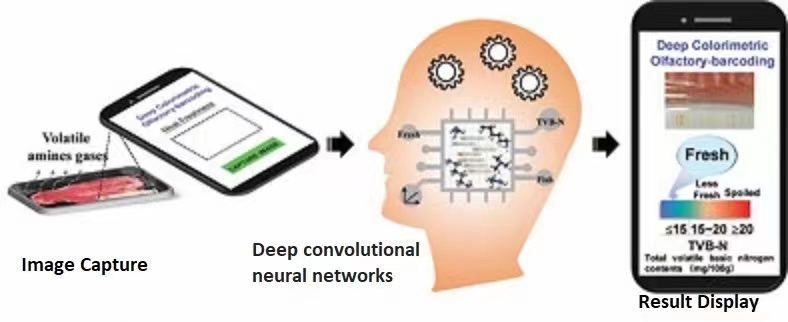

AI 鼻子预示了,多模态AI会成为一个"感官"比人类丰富得多的智能体 —— 我以前写过几篇东西讨论,人类相对AI有感知和认知上的优势,因为人类有五感,有触觉,嗅觉和味觉,这些暂时AI还不具备 —— 这个话现在看来不能再讲了,已经有好几款不同技术路线的AI NOSE出现了: 如附图,其中一种做法是让试纸去和气体反应,气体中不同成分(比如腐烂物质产生的化学物质)的含量会让试纸呈现不同颜色的视觉特性,用这种图形特性去训练一个视觉卷积神经网络,就能分辨出不同气味特性(当然这需要能对不同化学成分产生不同反应的试纸);另一种,微软的AI NOSE更直接,把气体传感器的数据输入到一个机器学习模型,训练这个机器学习模型根据传感器数据来分辨不同的气体。这两种方式,据说精准率都有98%以上。

这让我几乎看到人类的感知优势将不复存在,我们原以为多模态的感知信号需要复杂的系统来获取和融汇,对人体来说,确实如此。我们的器官和神经系统经过亿万年进化,成为极为精巧的传感器和反馈系统,让我们能把五感和激素,内分泌,神经元激活等等机制融合打通,用感觉实现自反省自监督学习。我以前也认为,这个系统是AI非常难以复制的,而我忽略的是,AI并不需要像人类那样分泌激素,调动情感,联通血脉,就可以完成任务 —— 只要任务是能转换为可计算形态的。而人类的生理反应和情绪有时候是一种学习力和创造力的来源,有时候其实对学习或者完成客观任务,并没有什么实质帮助,这种情况下,不依赖这种生理机制,反而成为了机器的优势,AI只需要把任何对完成任务有用的信息 —— 不管是视觉,听觉,还是触觉,热度,等等;不管是来自于传感器采集还是摄像头,声音设备 —— 统统数字化,转化到"隐性空间",在低向量维度上打通这些不同模态的信息,并用模态融合数据来关联,分析,特征提取和模式发现或创作 —— 文生图的模型就是一个最常见的把文字信息和图像信息打通的例子,前一阵Meta那个Imagebind,更是把声音视觉和传感器的惯性动量,热力学数据都"绑"到了一起。现在的AI NOSE,必然也会成为AI感知认知世界的一个模态,加入到多模态大模型中。不难想象,未来我们会用尽各种办法,把人类能感知,或者人类都无法感知的信息,转化为带特征的数字化信号,让AI来学习。AI也会成为一个更多维,更精细感知的智能体。—— 仅代表尹智个人观点 Ken's personal view only